Der Bühnenshow KÀ, des kanadischen Artistenzirkus Cirque du Soleil, unter Direktion von Robert Lepage liegt eine Geschichte zugrunde, was recht unüblich für den Cirque ist, da dessen Produktionen meist auf einem Thema beruhen. Die projizierten Bilder folgen dem Verlauf dieser Geschichte und begleiten sie als virtuelles Bühnenbild.

In mehr als zweijähriger Arbeit entstanden bis zur Premiere 2004 interaktive Projektionen, die in Echtzeit durch rein mathematische und physikalische Berechnungen erzeugt werden. Die Projektionen wurden im Jahre 2012 leicht überarbeitet und angepasst, um aktuellere Technik zu verwenden. Aufgrund der Weiterentwicklung der Computertechnik wurden Bildberechnungen möglich, die bei der Premiere der Show nicht in diesem Maße umsetzbar waren.

Zu den Projektionen gehören ein Pfeilhagel, Gewitterwolken, Meereswellen, eine Unterwasserszene, Stein- und Eislandschaften, leuchtende Lianen eines Waldes und Kaustiken einer künstlichen Wasseroberfläche. Einige der ursprünglichen Bilder sind in der 3D-Filmproduktion Cirque du Soleil: Traumwelten zu sehen.

umsetzung

Seit der Premiere von KÀ sind fast zehn Jahre vergangen, also habe ich mich entschlossen, mehr Informationen über die Technologie herauszugeben, die die Projektionen der Show antreibt. Ich schätze, dass inzwischen viele herausgefunden haben, wie die Prozesse zu bewältigen sind und dass sie inzwischen jedem offen stehen sollten. Warnung: Es wird sehr technisch. Im folgenden Text finden sich einige bisher unveröffentlichte Informationen zu den technischen Aspekten der Show.

hauptbühne / projektionsmapping

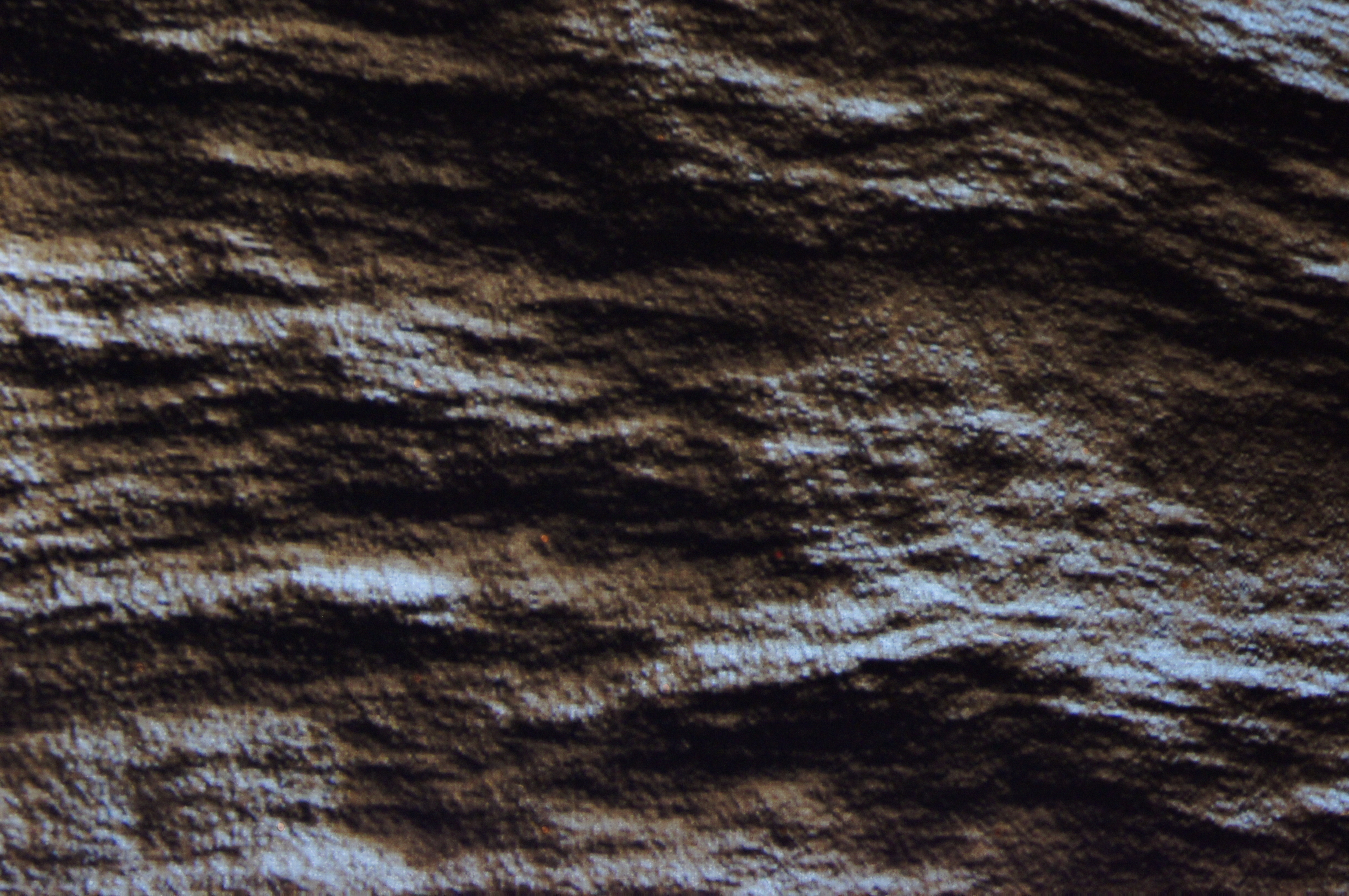

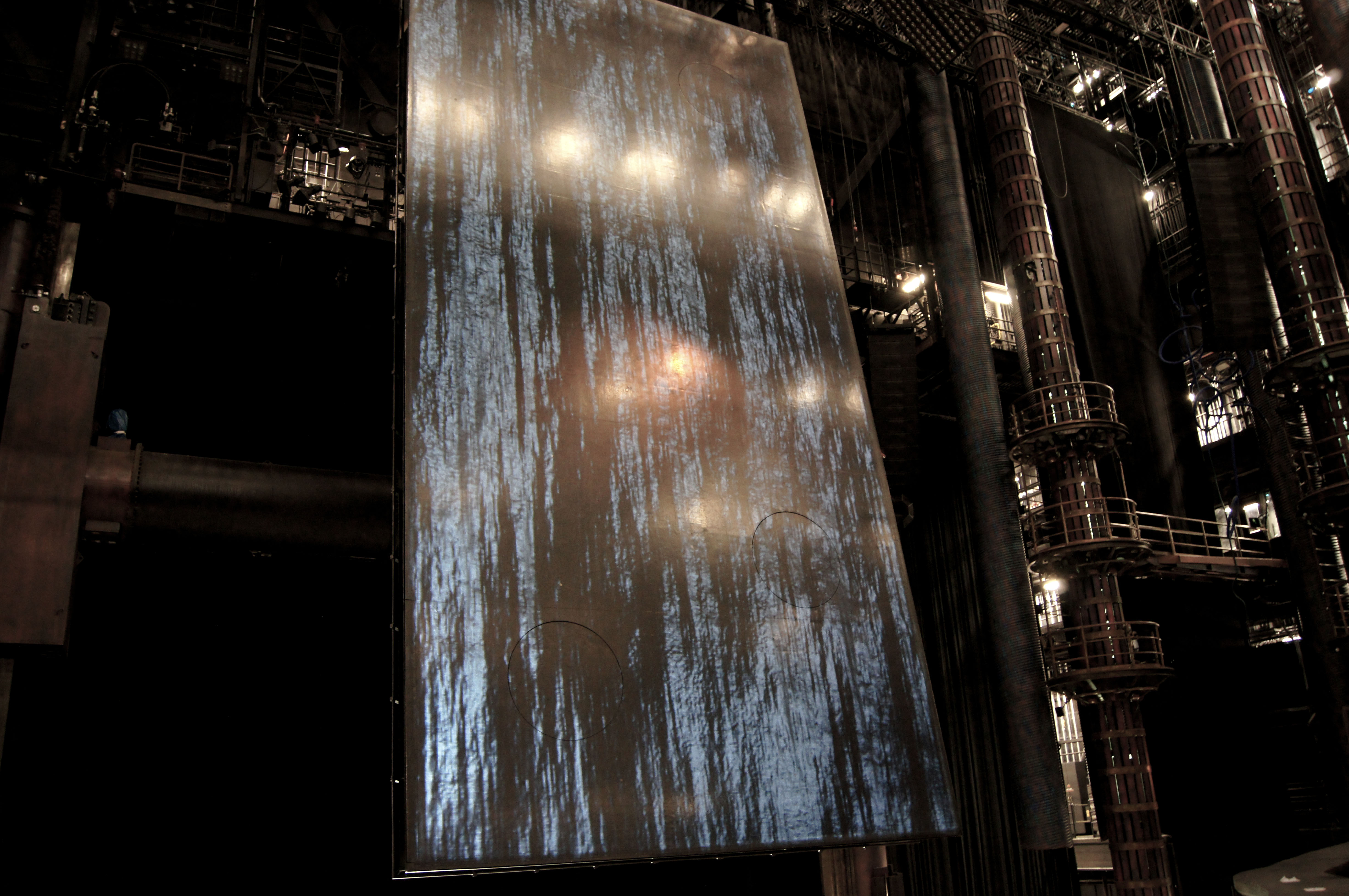

Eine Besonderheit des Systems ist das sogenannte Projektionsmapping auf eine in mehreren Freiheitsgraden bewegliche Bühne. Die Bilder bewegen sich mit der ca. 8x15m (25'x50') großen Hauptbühne, fast als wären sie aufgemalt. Licht- und Schattenwurf einer projizierten Steinoberfläche werden dabei z.B. in Echtzeit je nach Bühnenposition berechnet und auch eine interaktive Wasseroberfläche folgt den Bewegungen der Bühne in Echtzeit.

Hierzu wurden die Bühne, genannt Sand Cliff Deck, und weitere Teile des Theaters maßstabsgetreu im Computer nachgebildet. Die Position der realen Bühne wird durch Sensoren der Bühnenautomation erfasst und steuert ein virtuelles Gegenstück. Zusätzlich zur realen Hauptbühne gibt es also eine virtuelle Bühne im Rechner, die sich genau so bewegt wie das Original.

Um das Projektionsmapping zu realisieren, musste ich nun im virtuellen Raum für jeden Projektor eine virtuelle Kamera aufstellen. Die Optik der virtuellen Kamera muss der realen Projektoroptik exakt entsprechen. Projiziert man nun das Bild, das die virtuelle Kamera von der virtuellen Bühne filmt, fallen alle Pixel an ihren Platz und es sieht so aus als ob das, was man auf der virtuellen Bühne darstellt, auf der realen Bühne passieren würde.

Die größte Aufgabe war, die Mathematik zur Berechnung der Kamera Projektionsmatrix nur durch Angabe einer relativ kleinen Anzahl von Referenzpunkten im Theater zu lösen. Im ersten Ansatz ruckelte das Bild und reagierte verspätet auf die Bühnenbewegungen. Jedes interaktive Projektionssystem hat mit der Latenz, also der Zeitverzögerung zwischen Sensoreingabe und Bildausgabe und gegebenenfalls der Senderate der Sensoren zu kämpfen. In unserem Fall traf beides zu. Die Lösung war schließlich, mittels eines Kalman-Filters die Position der Bühne einige Millisekunden in die Zukunft vorherzusagen und dabei zu glätten.

Für die physikalische Projektion werden drei überlagerte DLP Projektoren für alle Bilder verwendet; ein Prozess bekannt als "stacking". Um die Bilder aller drei Projektoren im dreidimensionalen Raum genau auf einem Punkt der beweglichen Bühne zu konvergieren, muss jeder Projektor das zu projizierende Bild ein wenig anders verzerren. Eine gewisse Unschärfe in der Tiefe bleibt, da die Projektoren technisch bedingt nur in einer Ebene parallel zur Linse ganz scharf abbilden können.

Die Vorbühne wurde in der Projektionssoftware als dreidimensionale schwarze Maske programmiert, damit keine Projektion auf sie fällt. Das Schwarz von DLP-Projektoren ist darüber hinaus nie ganz schwarz sondern eher ein dunkles Grau, sogenanntes "video black". Um die Kante des rechteckigen Projektionsbereichs in sehr dunklen Szenen zu kaschieren, wurden steuerbare Irisblenden vor den Projektoren befestigt. Sie können graduell geschlossen werden, um an den Rändern des Bildes das Grau weich in Schwarz überblenden, oder vollständig geschlossen werden, wenn kein Bild projiziert wird.

interaktivität / sensoren

Dank des kanadischen Erfinders Philippe Jean von Les Ateliers Numériques sind im Boden der beweglichen Bühne Kapazitätssensoren eingelassen worden. Dadurch wird die gesamte Bühne, vereinfacht gesagt, zu einem großen, berührungssensitiven Display. Interaktionen der Akrobaten mit der Bühnenoberfläche sind also möglich – am Besten zu sehen bei der Interaktionen der Füße und des Körpers der Akrobaten mit der künstlichen Wasseroberfläche.

Eine Infrarotkamera, die nahes Infrarot filmt, wurde für die Unterwasserszene und die Lianen des Waldes zur Interaktionssteuerung eingesetzt. Zur Beleuchtung der Akrobaten sind hier Infrarotscheinwerfer im Theater platziert, deren Licht für das Publikum unsichtbar ist. Die Interaktion wird so unabhängig vom eingesetzten Bühnenlicht. Selbst bei Dunkelheit ist im Kamerabild alles zu sehen und die Interaktion funktioniert weiterhin.

Die Eingangsbilder der Kamera müssen so verzerrt werden, dass sie mit dem projizierten Bild zusammenfallen. Dies ist notwendig, da sich Positionen und Optiken der Infrarotkamera und Projektoren unterscheiden. So lösen Bewegungen im Kamerabild eine Reaktion an der richtigen Stelle der Projektion aus. Dichromatische Filter vor den Verfolgerscheinwerfern werden eingesetzt, um ihren Infrarotanteil zu eliminieren, so dass sie keine zusätzlichen Interaktionen auslösen.

algorithmische bilder und physik

Ausdrucksmittel meiner Arbeiten sind fast ausschließlich Algorithmen und Simulationen. Im Prinzip kann durch die Interaktion jedes Verhalten der Simulation und jeder Parameter im Erscheinungsbild gesteuert werden. Oft steht für mich dabei nicht das einzelne Bild im Vordergrund sondern vielmehr das Verhalten des Bildes in der Zeit.

Hinter den physikalischen Simulationen der Bilder liegen Mathematische Konstrukte. Grundlegende mathematische Repräsentationen der Bilder, in der aktualisierten Show von 2012, sind:

- Ein Partikelsystem für den Pfeilhagel

- Mehrere Schichten von Dichtefeldern für die Gewitterwolken

- Audioanalyse von Donnergeräuschen für die Blitze

- Gespiegelte Sinusschwingungen für die Meereswellen

- Partikel und 2.5D Reflexionsberechnungen für die Luftblasen

- überlagerte, verzerrte und in Echtzeit beleuchtete Fraktale für Stein und Eis

- Ketten von Sprungfedern für die Lianen

- Felder von Sprungfedern und Lichtbrechung für die Wasseroberfläche

konnektivität

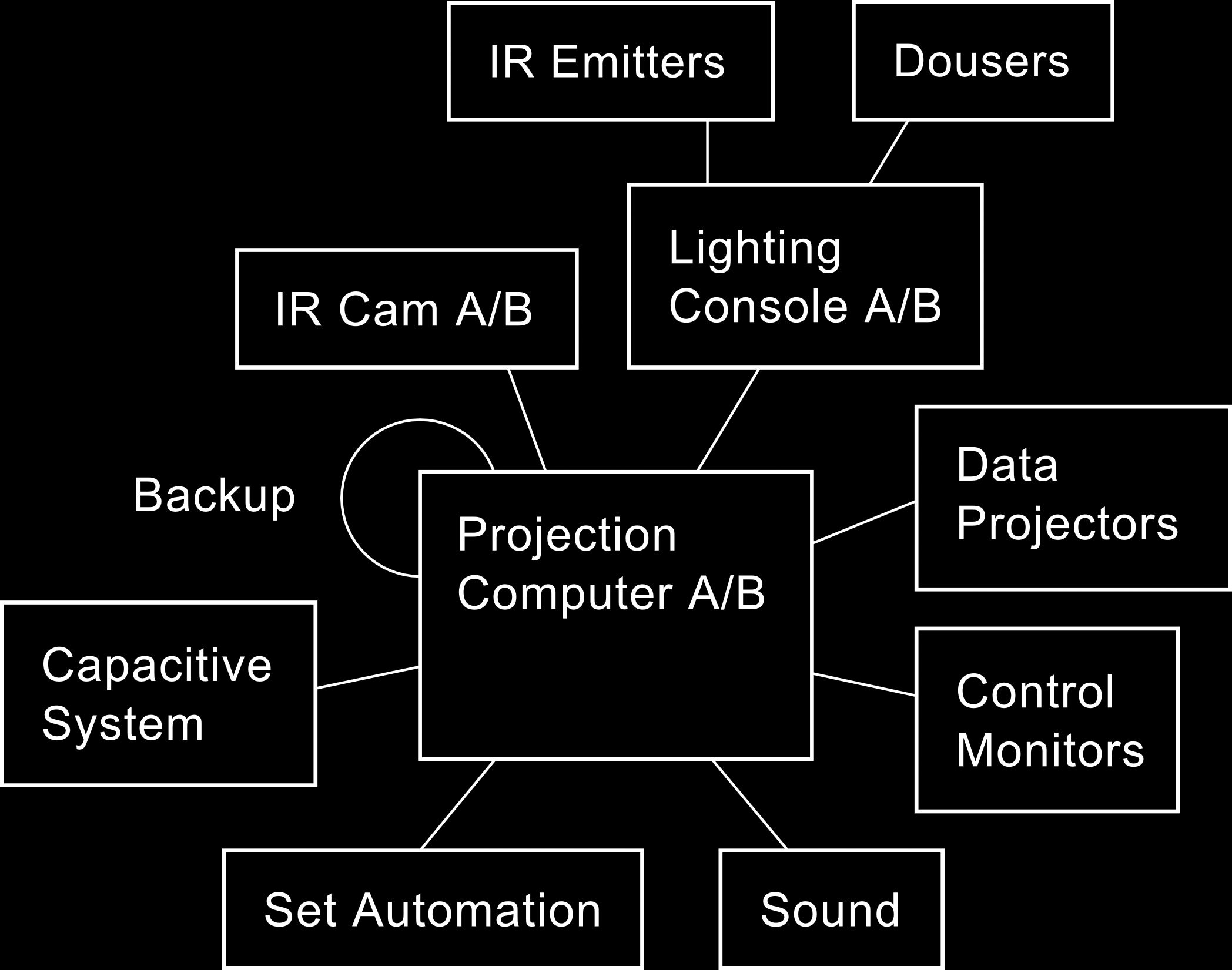

Eine enge Verzahnung mit anderen Systemen im Theater, bekannt als "show control", erhöht die Präsenz der Bilder und der mit ihnen verbundenen Elemente. Zum Beispiel triggern Donner der Klangabteilung Blitze in den Sturmwolken. Und die Bewegungen von Akrobaten unter Wasser erzeugen virtuelle Luftblasen und lösen korrespondierende Unterwasserklänge aus. Im schematischen Diagramm unten sind die wesentlichen, miteinander verbundenen Komponenten des Projektionssystems zu sehen.

Gesteuert wird das Projektionssystem durch ein Lichtpult. Alle essentiellen Elemente des Systems – Kameras, Lichtpult, Projektionscomputer und Projektoren – sind mehrfach vorhanden und so gegen einem Totalausfall abgesichert. Für die Computer existiert eine automatische Failover-Schaltung. Sollte also ein System ausfallen oder einfrieren, übernimmt das Reservesystem automatisch. Zu jedem Zeitpunkt kann der Konsolenoperator auch manuell auf die Reservesysteme schalten, sollte dies einmal notwendig sein.

Für noch mehr Informationen über die technischen Hintergründe der Show möchte ich auf die sehr kompetenten und umfassenden englischen Artikel von John Huntington in Lighting and Sound America und den neueren Artikel von Davin Gaddy zur überarbeitung von 2012 verweisen.

beteiligte

kreation 2004

Mein größter Dank gebührt Guy Laliberté und Robert Lepage, dafür dass sie verrückt und mutig genug waren, mir die Rolle der Projektionsgestaltung zu übergeben. Das Projekt war zigmal größer als alle Projekte, an denen ich bis dahin beteiligt war. Guy Caron und Stéphane Mongeau danke ich für die außergewöhnlich gute Planung und Bändigung des Gesamtprojekts. Vielen Dank auch dem Team der Schöpfer dieser Show für die enge Zusammenarbeit und kollegiale Atmosphäre. Das kreative Team waren:

| Guide | Guy Laliberté |

| Creator and Director | Robert Lepage |

| Set Designer | Mark Fisher |

| Costume Designer | Marie-Chantale Vaillancourt |

| Composer and Arranger | René Dupéré |

| Choreographer | Jaques Heim |

| Lighting Designer | Luc Lafortune |

| Sound Designer | Johnathan Deans |

| Interactive Projections Designer | Holger Förterer |

| Puppet Designer | Michael Curry |

| Props Designer | Patricia Ruel |

| Acrobatic Equipment and Rigging Designer | Jaque Paquin |

| Aerial Acrobatics Designer | André Simard |

Madeleine Jean und Dominik Rinnhofer danke ich für ihre Assistenz, die mir in besonders stressreichen Zeiten eine große Stütze war. Ohne sie wäre manches Kunststück nicht so glatt über die Bühne gegangen. Ich hatte zur Umsetzung der Software die Unterstützung von vier sehr begabten Programmierern: Peter Ibrahim, Mykel Brisson, Daniel Fournier und Alain Trépanier. über die Planung der Hardware hatte Steve Montambault die Hoheit. Philippe Jean und Louis-Philippe Demers danke ich besonders für die damals wahnwitzige Umsetzung des riesigen kapazitiven Systems.

Danke an alle Verantwortlichen der Lichtabteilung, der wir als Projektionsteam angehörten, vor allem Jeanette Farmer und Nils Becker für Lösungen zu all den Dingen, die auf den ersten Blick unmöglich erschienen; dem Projektionsleiter Jon Mytyk und Tony Saurini für die enge und produktive Zusammenarbeit zu allen möglichen und unmöglichen Tages- und Nachtzeiten; sowie allen Licht- und Bühnentechnikern, insbesondere Liz Koch.

Jörg Lemke danke ich herzlich für die vielen Stunden der Diskussion über künstlerische Konzepte und das Leben. Für die Zusammenarbeit möchte ich mich noch bei Neilson Vignola, Anh-Dao Bui und Simon Lemieux bedanken. Last, but not least, bei Jeremy Hodgson von der Automation und Nol Van Genuchten für die Hilfe während der Planungsphase des Lichts.

Da ein solch großes Projekt mehr als etwas unübersichtlich werden kann, bitte ich alle ganz herzlich um Entschuldigung, die ich in dieser langen Liste vergessen haben mag.

überarbeitete version 2012

Danke an den neuen Projektionsleiter Davin Gaddy für die außerordentlich unkomplizierte Zusammenarbeit und seine vielen guten Ideen. Nils Becker und Chris Kortum danke ich für die Planung und überwachung der Ausführung und für schnelle Hilfe, wenn etwas mal nicht sofort funktionierte. Für die hilfreiche Unterstützung möchte ich auch dem technischen Leiter Erik Walstad und der künstlerische Leiterin Marie-Hélène Gagnon danken.

Christian Wening und seinem Team schulde ich viel Dank für die wie immer kompetente Hardwarerecherche und den Zusammenbau der neuen Projektionscomputer.

Schließlich noch vielen Dank an Davin Gaddy für die Durchsicht des englischsprachigen Textes dieser Dokumentation.